Tối ưu Inference-Time: Hiệu quả hơn Scaling Parameters?

[Arxiv 2024]: Scaling LLM Test-Time Compute Optimally can be More Effective than Scaling Model Parameters

Publish Day: 6/8/2024

Link: https://arxiv.org/pdf/2408.03314

Bối cảnh vấn đề

OpenAI gần đây được nhắc đến nhiều vì 2 lý do:

- Thất bại trong việc tạo ra 'quái thú' GPT-5.

- Thất bại trong việc cập nhật GPT-4o, khi phiên bản gần nhất cho kết quả tệ hơn chính nó 3 tháng trước.

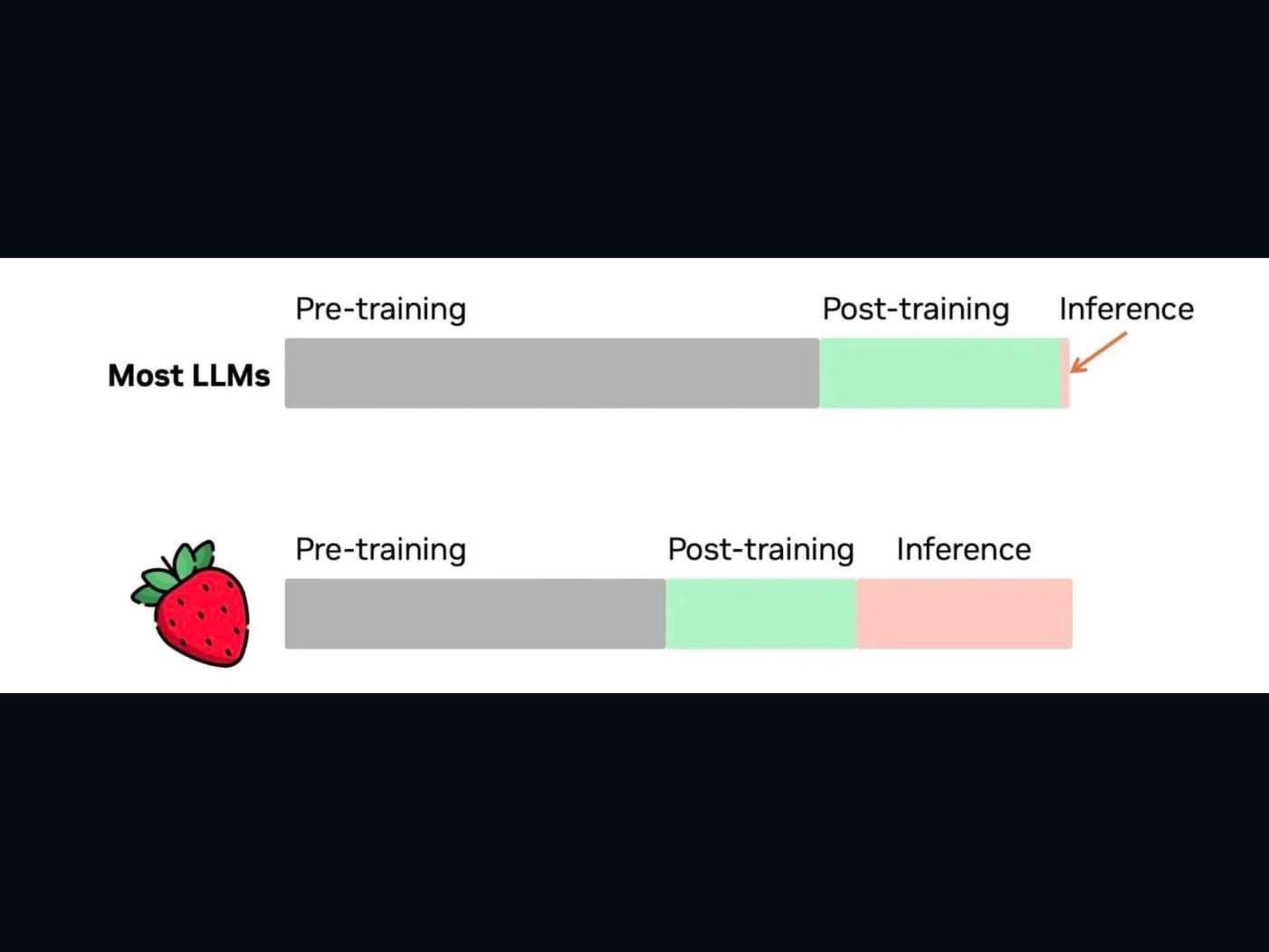

Điều này đáng quan ngại vì chính OpenAI đã đặt nền móng cho giả thuyết: “The more the model params increase, The more effective it becomes”. Tận dụng cơ hội này, Google cho rằng tài nguyên nên được ưu tiên cho việc scaling inference (tối ưu lúc suy luận) hơn là scaling parameters (tăng kích thước mô hình).

Nội dung chính của paper

- Scaling trong lúc inference: Paper giới thiệu hướng nghiên cứu tập trung vào việc tối ưu và tăng cường tính toán trong giai đoạn inference thay vì chỉ tập trung vào việc huấn luyện các mô hình lớn hơn.

- Smarter Models, Not Just Bigger ones: Mô hình lớn có khả năng reasoning cao, nhưng cũng có xu hướng 'học vẹt' (memorize) thay vì suy luận thực sự. Paper đặt ra câu hỏi mở:

“But what if we separate reasoning from knowledge?”

Nghĩa là, chúng ta có thể dùng một mô hình nhỏ hơn, chỉ đủ để 'suy luận' về cách giải quyết một tác vụ (ví dụ: nên dùng công cụ ngoài hay không), và dành phần lớn tài nguyên tính toán còn lại cho quá trình inference-time.

- Tiên đoán về kỹ thuật của o1: Paper này ra đời chỉ 2 ngày sau khi gpt-o1 được công bố, phần nào giải thích và tiên đoán các kỹ thuật được sử dụng bên trong. Cụ thể là chiến lược inference-time: mô hình sinh ra N giải pháp tiềm năng, sau đó áp dụng các thuật toán như Monte Carlo Tree Search để tìm ra giải pháp tối ưu nhất làm câu trả lời cuối cùng.

Lời kết

Nói chung, như đã dự đoán, khả năng trong những năm tới sẽ có nhiều hướng nghiên cứu chú trọng vào việc tối ưu hóa inference. Các bạn sinh viên thích làm nghiên cứu có thể tham khảo hướng đi này, biết đâu lại có paper 😋